Файл robots — это текстовый файл, он имеет огромную роль в индексации сайта, он помогает «понять» поисковым системам, что необходимо брать в поиск из страниц, что следует закрывать от индексации от поискового робота, какие файлы они могут использовать для рендеринга и кеширования, а так же какие ссылки на важные файлы и главные зеркала. В интернете можно прочитать, что поисковики сейчас не учитывают директивы из роботса, но скажу вам с 100% уверенностью – Яндекс ему следует полностью. Гугл тоже, но бывают моменты, что он все-таки индексирует закрытые страницы, но это редко. В статье разберем примерные стартовые конфигурации правильной настройки robots.txt для разных CMS. В конце примеры сервисов Яндекса, Google и сторонних для анализа файла robots.txt.

Этот вариант предпочтителен по сравнению со вторым, поскольку отсутствует риск случайно запретить индексацию каких-либо файлов внутри основной директории WordPress или в папке wp-content:

User-agent: *

Disallow: /wp-

Disallow: /tag/

Disallow: */trackback

Disallow: */page

Disallow: /author/*

Disallow: /template.html

Disallow: /readme.html

Disallow: *?replytocomDisallow: */feed/*Disallow: */feed/

Allow: */uploads

Allow: *.js

Allow: *.css

Allow: *.png

Allow: *.gif

Allow: *.jpg

Sitemap: https://site.ru/sitemap.xmlHost: https://site.ru/Disallow: /cart/Disallow: /checkout/Disallow: /*add-to-cart=*Disallow: /my-account/Загружать роботс следует в корень сайта, там где находятся папки wp-content, wp-admin и wp-includes. Для этого понадобиться FTP доступ.

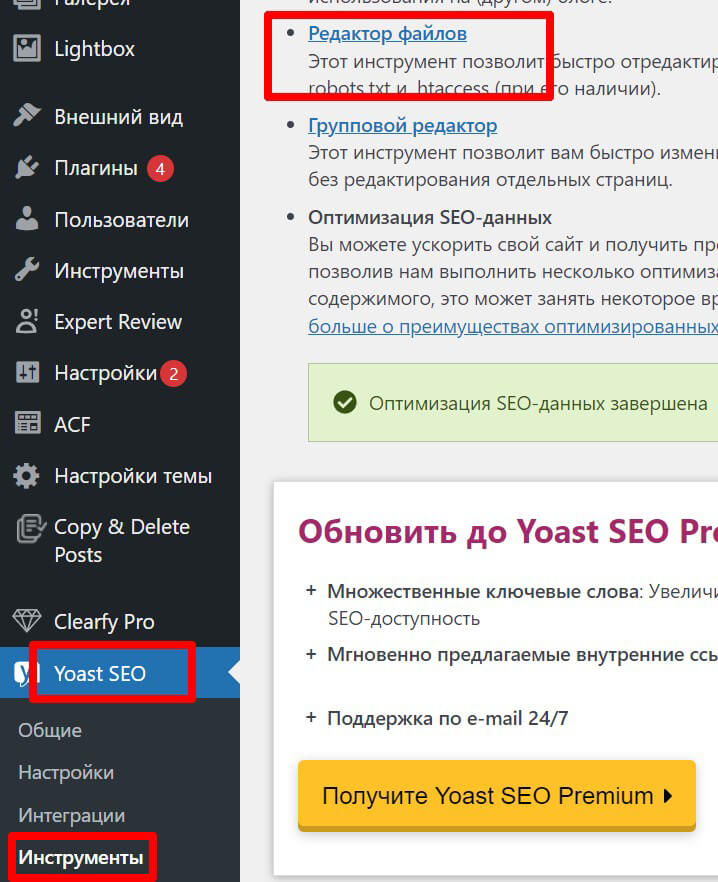

Если вы не хотите возиться с FTP и на ресурсе установлен плагин YoastSEO, то вы можете сделать физический роботс (есть еще виртуальный) в нем. Переходим по таким пунктам, как на нижнем скриншоте. Если у вас нет роботса, то система предложит его создать соответствующей кнопкой.

Физический – значит он создан из файлов и залит на сервер, то есть его можно увидеть в корне сайта. Виртуальный – значит что его создает PHP скрипт, тоже метод хороший, для этого есть множество плагинов, например Virtual Robots.txt, думаю показывать нет необходимости, там все интуитивно понятно.

Битрикс — очень большая и насыщенная различным функционалом CMS (система управления контентом), поэтому она генерирует огромное количество страниц с параметрами и другими включениями, одна только функция фильтрации может сделать до 10 различных комбинаций URL, что очень плохо будет влиять на SEO. Индексацию можно просто убить, если не настроить robots для Bitrix.

User-agent: * # правила для всех роботов

Disallow: /cgi-bin # папка на хостинге

Disallow: /bitrix/ # папка с системными файлами битрикса

Disallow: *bitrix_*= # GET-запросы битрикса

Disallow: /local/ # папка с системными файлами битрикса

Disallow: /*index.php$ # дубли страниц index.php

Disallow: /auth/ # авторизация

Disallow: *auth= # авторизация

Disallow: /personal/ # личный кабинет

Disallow: *register= # регистрация

Disallow: *forgot_password= # забыли пароль

Disallow: *change_password= # изменить пароль

Disallow: *login= # логин

Disallow: *logout= # выход

Disallow: */search/ # поиск

Disallow: *action= # действия

Disallow: *print= # печать

Disallow: *?new=Y # новая страница

Disallow: *?edit= # редактирование

Disallow: *?preview= # предпросмотр

Disallow: *backurl= # трекбеки

Disallow: *back_url= # трекбеки

Disallow: *back_url_admin= # трекбеки

Disallow: *captcha # каптча

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: *?FILTER*= # здесь и ниже различные популярные параметры фильтров

Disallow: *?ei=

Disallow: *?p=

Disallow: *?q=

Disallow: *?tags=

Disallow: *B_ORDER=

Disallow: *BRAND=

Disallow: *CLEAR_CACHE=

Disallow: *ELEMENT_ID=

Disallow: *price_from=

Disallow: *price_to=

Disallow: *PROPERTY_TYPE=

Disallow: *PROPERTY_WIDTH=

Disallow: *PROPERTY_HEIGHT=

Disallow: *PROPERTY_DIA=

Disallow: *PROPERTY_OPENING_COUNT=

Disallow: *PROPERTY_SELL_TYPE=

Disallow: *PROPERTY_MAIN_TYPE=

Disallow: *PROPERTY_PRICE[*]=

Disallow: *S_LAST=

Disallow: *SECTION_ID=

Disallow: *SECTION[*]=

Disallow: *SHOWALL=

Disallow: *SHOW_ALL=

Disallow: *SHOWBY=

Disallow: *SORT=

Disallow: *SPHRASE_ID=

Disallow: *TYPE=

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Disallow: *from= # ссылки с метками from

Allow: */upload/ # открываем папку с файлами uploads

Allow: /bitrix/*.js # здесь и далее открываем для индексации скрипты

Allow: /bitrix/*.css

Allow: /local/*.js

Allow: /local/*.css

Allow: /local/*.jpg

Allow: /local/*.jpeg

Allow: /local/*.png

Allow: /local/*.gif

# Укажите один или несколько файлов Sitemap

Sitemap: http://site.ru/sitemap.xml

User-agent: * # правила для всех роботов

Disallow: /cgi-bin # папка на хостинге

Disallow: /manager/ # авторизация

Disallow: /assets/ # папка с системными файлами modx

Disallow: /core/ # папка с системными файлами modx

Disallow: /connectors/ # папка с системными файлами modx

Disallow: /index.php # дубли страниц index.php

Disallow: *?* # ссылки с параметрами

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Disallow: *from= # ссылки с метками from

Allow: /assets/*.jpg # здесь и далее открываем для индексации изображения, файлы и скрипты

Allow: /assets/*.jpeg

Allow: /assets/*.gif

Allow: /assets/*.png

Allow: /assets/*.pdf

Allow: /assets/*.doc

Allow: /assets/*.docx

Allow: /assets/*.xls

Allow: /assets/*.xlsx

Allow: /assets/*.ppt

Allow: /assets/*.pptx

Allow: /assets/*.js

Allow: /assets/*.css

Allow: *?page= # открываем для индексации страницы пагинации (и проверьте, чтобы для них был настроен canonical)

# Укажите один или несколько файлов Sitemap

Sitemap: http://site.ru/sitemap.xml

Для MODX Revo дополнительно можно указать такую строку Disallow: /assets/components/

Правильный роботс будет таким:

User-agent: *

Disallow: /*route=account/

Disallow: /*route=affiliate/

Disallow: /*route=checkout/

Disallow: /*route=product/search

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /admin

Disallow: /catalog

Disallow: /system

Disallow: /*?sort=

Disallow: /*&sort=

Disallow: /*?order=

Disallow: /*&order=

Disallow: /*?limit=

Disallow: /*&limit=

Disallow: /*?filter_name=

Disallow: /*&filter_name=

Disallow: /*?filter_sub_category=

Disallow: /*&filter_sub_category=

Disallow: /*?filter_description=

Disallow: /*&filter_description=

Disallow: /*?tracking=

Disallow: /*&tracking=

Disallow: /*compare-products

Disallow: /*search

Disallow: /*cart

Disallow: /*checkout

Disallow: /*login

Disallow: /*logout

Disallow: /*vouchers

Disallow: /*wishlist

Disallow: /*my-account

Disallow: /*order-history

Disallow: /*newsletter

Disallow: /*return-add

Disallow: /*forgot-password

Disallow: /*downloads

Disallow: /*returns

Disallow: /*transactions

Disallow: /*create-account

Disallow: /*recurring

Disallow: /*address-book

Disallow: /*reward-points

Disallow: /*affiliate-forgot-password

Disallow: /*create-affiliate-account

Disallow: /*affiliate-login

Disallow: /*affiliates

Disallow: /*?filter_tag=

Disallow: /*brands

Disallow: /*specials

Disallow: /*simpleregister

Disallow: /*simplecheckout

Disallow: *utm=

Allow: /catalog/view/javascript/

Allow: /catalog/view/theme/*/

Sitemap: https://site.ru/index.php?route=feed/google_sitemap

Ссылка на xml карту сайта может быть другой, сейчас указана стандартная, вы прописываете свой URL если он отличается.

Советы по составлению файла роботс: